(Перед вами перевод бесплатного курса по A/B тестированию от компании Dynamic Yield. Если вы здесь впервые, то лучше начните сначала)

Автор английской версии: Янив Навот, CMO, Dynamic Yield

Регулярная оптимизация и персонализация пользовательского опыта для повышения KPI — это важный и ценный инструмент роста эффективности любого онлайн-бизнеса. Сегодня эта практика является обязательным компонентом любой экосистемы цифрового маркетинга. Однако есть один нюанс: могут ли наши усилия по оптимизации и персонализации негативно сказаться на SEO?

С этой темой связано множество заблуждений, поэтому мы разберем самые популярные страхи и приведем официальные комментарии от Google по этому поводу, а также дадим ряд практических советов, чтобы при проведении своих кампаний по оптимизации пользовательского опыта вы чувствовали себя спокойно и уверенно. Кроме того, мы поделимся результатами экспериментов, которые мы сами проводили в Dynamic Yield, чтобы выяснить как динамический контент, сгенерированный через JavaScript, влияет на SEO (в том числе на Google-краулинг и индексацию).

И еще пара комментариев, прежде чем мы начнем:

- В этой статье мы будем говорить только про динамический контент, сгенерированный через JavaScript. (A/B тестирование и персонализация может рендериться и на стороне клиента, и на стороне сервера — почитать подробнее можно здесь)

- Если хотите подробнее узнать, как Google наказывает за навязчивые “межстраничные” рекламные объявления, почитайте эту статью о влиянии поп-апов, плашек-оверлеев и межстраничных объявлений на SEO.

Итак, начнем.

Могут ли A/B тесты или кампании по персонализации навредить ранжированию в Google?

Google старается создавать все условия, чтобы владельцы сайтов и маркетологи могли проводить конструктивные тесты и постоянные оптимизации страниц. Компания даже предлагает собственную платформу как раз для этих целей. Идея в том, что персонализация работает не против пользователей — а наоборот в их интересах. Совершенствуя цифровой опыт взаимодействия, компании поднимают метрики вовлеченности, повышают лояльность клиентов и, как результат, строят более сильный бренд.

Вот что пишет на Reddit AMA Джон Мюллер, аналитик трендов Google для веб-мастеров: “Персонализация — это хорошо, временами она очень уместна и оправдана”.

Тем не менее, хоть Google и поощряет попытки маркетологов совершенствовать страницы и постоянно улучшать пользовательский опыт, с технической точки зрения существует 4 ключевых риска, о которых нужно помнить при оптимизации и персонализации веб-страниц:

- Клоакинг (cloaking)

- Редиректы

- Дублирование

- Скорость

Риск №1: Клоакинг

Клоакинг — это когда вы показываете поисковым ботам одну версию страницы, а посетителям сайта — другую. Клоакинг используют как махинацию для повышения органического ранжирования и с точки зрения SEO это огромный риск, потому что метод является грубым нарушением официального руководства Google для веб-мастеров. Другими словами, проведение кампаний по оптимизации, где вы показываете юзер-агентам (таким как GoogleBot) одну версию страницы, а живым пользователям другую — это большой ай-яй.

Чтобы не было проблем, придерживайтесь принципа: GoogleBot и другим поисковым ботам следует относиться так же, как в настоящим пользователям. Если вы намеренно не таргетите определенный контент на ботов, а другой — на пользователей, ваши кампании никогда не сочтут манипуляцией с клоакингом.

В идеале, в ходе тестирования нужно взаимодействовать с GoogleBot как с любым другим пользователем. Не нужно выделять ботов в отдельный сегмент и создавать версию специально под них — это уже будет считаться клоакингом.

— Джон Мюллер, Google

Риск №2: Не тот тип редиректа

При редиректе посетителей на URL конкретной вариации (например, как при сплит-тестах), официальное руководство Google предписывает всегда использовать временный код ответа HTTP (302 Found) или редирект на основе JavaScript. Возьмите за правило не использовать код ответа HTTP 301 “Перемещено навсегда”. Код ответа 302 дает понять поисковым машинам, что редирект временный и что нужно продолжать индексировать оригинальный канонический URL.

Риск №3: Дублирование URL и контента

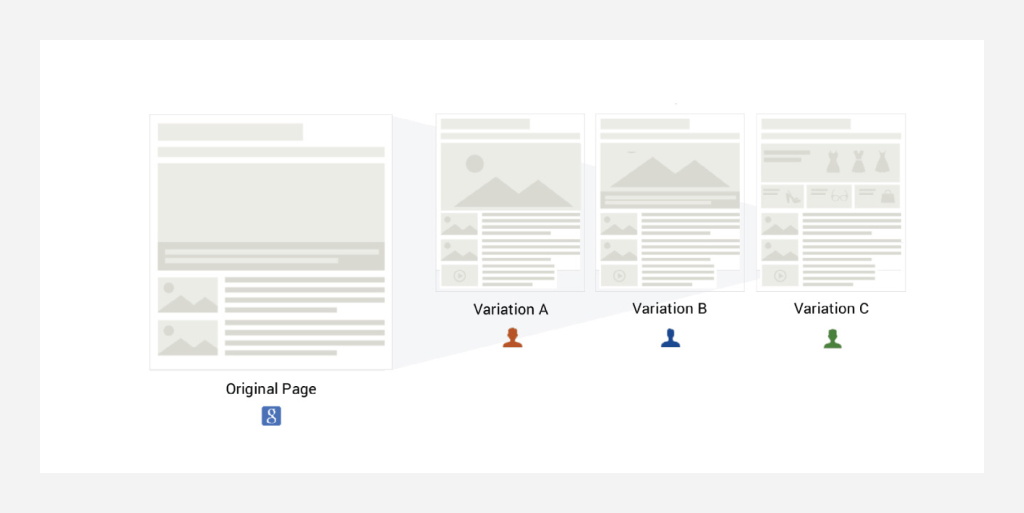

Дублирование URL — это когда при проведении онлайн-экспериментов система дублирует некоторые URL сайта под разные тестовые вариации.

С точки зрения SEO риск того, что подобные дубликаты попадут под реальное наказание, относительно низкий — если только вы не создаете дубликаты специально для повышения органического ранжирования через клоакинг.

Тем не менее, чтобы полностью застраховаться от возможных рисков, рекомендуем довольно простой метод — добавить на каждый дублирующийся URL тег canonical указывающий на каноническую страницу. Также можно заблокировать доступ к этим дубликатам с помощью простой команды Disallow в Robots.txt или метатега Robots со значением noindex.

Дублирование контента — это когда оптимизация и персонализация сайта подразумевает, что мы показывает разным посетителям разные вариации контента. Если оригинальный контент страницы сильно влияет на ее органическое ранжирование, очень важно всегда оставлять этот контент на странице — то есть полностью не заменять его динамически-сгенерированным контентом. Плюс, если вы сохраните оригинальный контент, он будет служить неким запасным аэродромом для тех посетителей (или групп посетителей), кто не попал под действие теста.

Google становится все умнее, и его алгоритмы краулинга и индексирования теперь могут рендерить и понимать (в определенной мере) тэги нашего динамического контента на основе JavaScript — и даже могут индексировать сам контент.

Риск №4: Скорость загрузки веб-страниц

С точки зрения пользовательского опыта, скорость сайта часто является определяющим фактором. С 2010 года этот показатель включен в алгоритмы органического ранжирования Google, наряду с другими 200+ факторами ранжирования. Некоторые пользователи беспокоятся, что инструменты по оптимизации и персонализации могут негативно повлиять на время загрузки страниц — и, сказать по правде, такая вероятность есть. Но есть и способы минимизировать это влияние.

- Настройте скрипт отслеживания асинхронно — таким образом он будет подгружаться одновременно и не будет замедлять страницу. Хотя асинхронная загрузка скрипта позволяет не снижать скорость загрузки страницы, может появиться эффект “мерцания” (flickering), когда сначала подгружается оригинальная страница, а потом включается вариация. Dynamic Yield, к примеру, использует синхронный сниппет, который помогает избежать мерцания и минимизировать влияние на скорость загрузки страницы.

- Настройте предварительный выбор (prefetch) и предварительное подключение (preconnect) к DNS — теги предварительного выбора и предварительного подключения к DNS обеспечат дополнительный буст для браузеров отличных от IE. Предварительное подключение позволяет браузеру установить раннее соединение до фактической отправки HTTP-запроса на сервер. Сюда входят поиск DNS, согласование TLS и процедура рукопожатия TCP. Это, в свою очередь, устраняет круговую задержку (roundtrip latency) и экономит время пользователям.

- Используйте ленивую загрузку (lazy loading) — включите ленивую загрузку (которую, кстати, Dynamic Yield поддерживает по умолчанию), чтобы эксперименты могли запускаться асинхронно (например, ниже линии сгиба).

- Используйте собственную CDN — чтобы ваш сайт не зависел от внешних факторов. Можно выбрать того поставщика CDN, который соответствует вашему текущему контракту с CDN и гарантирует наличие серверов как можно ближе к вашим посетителям. Таким образом ваши собственные сервера смогут оптимизировать время загрузки, поскольку у них будет полный контроль над отображаемым контентом. К примеру, мы в Dynamic Yield работаем с облачными серверами Amazon (Amazon Cloud Servers) и доставляем контент напрямую через их серверы CDN.

- Переходите на тестирование на стороне сервера — персонализацию и A/B тестирование можно запускать не только на стороне клиента, но и на стороне сервера. Когда эксперименты реализуются на стороне сервера, на эффективность страницы они не влияют вообще. К примеру, поддержвает запуски как на стороне клиента, так и на стороне сервера. API на стороне сервера позволяют интегрировать персонализацию как основую часть вашего технологического стека и избежать “мерцания”, что ускоряет загрузку страницы.

Контент на основе JavaScript и ранжирование

Google использует некое подобие безголового браузера для рендеринга JavaScript кода и имитации пользовательского опыта реальных пользователей. Google использует эту технологию, потому что стремится в полной мере понять поведение пользователей в интернете (не то что раньше, когда они использовали только “простых” ботов, чтобы извлекать из страниц тексты, медиа и ссылки). При этом неясно, умеет ли Google сопоставлять разные сессии с параметрами пользователей — и практикует ли это для выявления персонализированных или тестовых вариаций контента. К примеру, будет ли Googlebot сканировать (краулить) одну и ту же страницу из разных стран, чтобы распознать её как локальную персонализацию? Скорее всего нет, хотя в теории он может это сделать при необходимости. Хотя Googlebot работает в основном на территории США, они утверждают, что иногда проводят локальное сканирование; проверить можно только проанализировав логи серверов.

Ранее, Google опубликовал официальное заявлял о своих возможностях рендеринга JavaScript, в котором говорилось, что “иногда не все идет гладко в процессе рендеринга, что может негативно повлиять на место вашего сайта в выдаче”.

Поэтому при создании динамических вариаций контента настоятельно рекомендуем добавить в исходный код оригинальный статический контент.

Таким образом: мы не рекомендуем использовать платформу персонализации для динамической модификации контента, важного с точки зрения SEO.

Вместо этого, стоит убедиться, что важный для SEO контент присутствует в статическом исходном коде страниц. Таким образом, вы перестрахуетесь: пользователи, чей опыт взаимодействия не персонализирован (а также и те, чей браузер не поддерживает JS), увидят базовый “запасной” контент. Кроме того, вы сделаете так, что большинство ботов (и в том числе Googlebot) будут сканировать контент, который отвечает вашей SEO-стратегии. Можно полагать, что в общем и целом алгоритмы ранжирования Google ориентируются на дефолтную, статичную версию страницы — а не на потенциально огромное количество персонализированных вариаций, которые могут существовать вокруг этой страницы.

Влияние JavaScript-контента на SEO сайта еще не изучено в полной мере. Мы сами протестировали то, как Googlebot сканирует и индексирует контент на основе JavaScript.

Ниже приведены результаты наших экспериментов: мы стремились выяснить, как наши возможности по динамической персонализации (изменение контента, дизайна и лейаута) влияют на SEO (включая краулинг и индексацию).

Тесты — шесть разных реализаций на стороне клиента

Методы — Динамический контент (inline), Динамический контент (placement), Динамический контент (Inline Placement), Динамический контент (Custom Action JS), Рекомендации (Placement), Рекомендации (Inline-Placement)

Проверка — для проверки отображения динамического контента в выдаче Google мы использовали уникальные фразы

Итак, может ли Google сканировать и индексировать контент на основе JavaScript?

Вывод — Да, Google отсканировал и проиндексировал весь контент на основе JavaScript

Контент, сгенерированный при помощи JavaScript (динамический контент), кастомные действия и рекомендации, предложенные алгоритмом отображаются в выдаче Google (SERP) в виде простого текста. Результаты подтвердились для всех методов реализации, которые мы тестировали.

Глубже изучить весь наш JavaScript SEO эксперимент можно по ссылке: dynamicyield.com/seo.

Пример SEO-дружественной оптимизации на стороне клиента

Оберните статический контент внутри контейнера определенным CSS селектором и замените статический контент внутри этого CSS селектора новыми, динамически-сгенерированными вариациями контента.

Затем мы будем использовать теги динамического контента, чтобы персонализировать пользовательский опыт посетителей сайта, динамически заменяя контент, дизайн и лейаут страниц.

Это никак не повлияет на ранжирование, потому что Googlebot будет видеть статичную версию страницы.

Вывод и рекомендация

Google признает, что A/B тестирование и персонализация необходимы для совершенствования клиентского опыта, и его поисковые алгоритмы умеют сканировать и индексировать контент, сгенерированный через JavaScript. Маркетологам, которые беспокоятся о влиянии экспериментов на SEO, мы рекомендуем использовать при тестировании только проверенные практики — так вы избежите ненужных наказаний. Надеемся, что наша статья помогла вам набраться уверенности в этом вопросе.

← Назад | Продолжение (Глава 13) →